作ってわかる!自然言語処理AI〜BERT・GPT2・NLPプログラミング入門

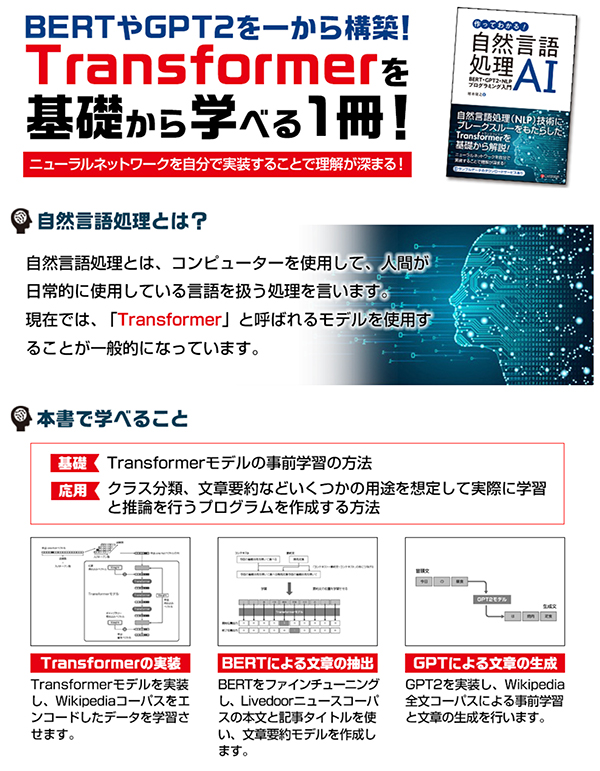

最新の自然言語処理(NLP)では、Transformerという種類のニューラルネットワークが使われるようになりました。

TransformerはBERTやGPT2などのAIで採用され、NLP技術にブレークスルーをもたらしましたが、その特徴は、高い性能とさまざまな用途に使える汎用性の高さにあります。

本書では、Transformerの構造を理解するためにBERTとGPT2を一から実装し、またNLPプログラムを作成するために必要となる、Transformerを拡張して応用AIを作成する方法を紹介します。

Transformerの実装では、Transformerの中心となるSelf-Attention層の作成やテキストのエンコード方法など、最も基礎的な部分から、Pythonのコードをもとに解説をしています。

また、学習では、事前学習と特定のタスクに向けたファインチューニングという、Transformerに特徴的な2段階のステップを、両方とも行います。

ニューラルネットワークの実装は、TensorFlow 2を利用します。

目次

CHAPTER 01 Transformerとは

CHAPTER 02 自然言語処理の前準備

CHAPTER 03 Self-Attentionと学習の準備

CHAPTER 04 Transformerの実装

CHAPTER 05 BERT

CHAPTER 06 BERTによるテキスト分類

CHAPTER 07 文章の抽出

CHAPTER 08 GPT2

CHAPTER 09 抽象型文章要約

著者紹介

坂本 俊之(サカモト・トシユキ)

機械学習エンジニア・兼・AIコンサルタント

現在はAIを使用した業務改善コンサルティングや、AIシステムの設計・実装支援などを行う。

担当編集者から

本書ではBERTやGPT2を自分で実装する内容になっています。そうすることで動作原理などの理解につなげる目的です。ぜひ、本書で実装にチャレンジしてみてください。(吉成)